Cássia Hosni Pesquisa da Revista Fapesp aponta levantamento realizado com 5 mil pesquisadores de mais de 70 países. Segundo o artigo publicado na Revista Fapesp, em junho de 2025, para a maioria dos entrevistados, a…

Posts tagged metodologias

ARQUIVO LÉSBICO BRASILEIRO (ALB): PRODUÇÃO E PRESERVAÇÃO DA MEMÓRIA LÉSBICA

Rian Souza De acordo com o pesquisador Jack Halberstam, para a cultura queer, os arquivos têm funcionado como uma teoria de relevância cultural, uma construção de memória coletiva e um registro complexo da atividade da…

GALA QUEER ARCHIVE: TECNOCONSCIÊNCIAS QUEER NA ÁFRICA DO SUL

Rian Souza Nesse mês do orgulho LGBTQIA+ trazemos uma reflexão do filósofo espanhol Paul B. Preciado a partir do seu conceito de “Tecnoconsciências”. Nesse sentido, o autor chama a atenção de que é necessário deixar…

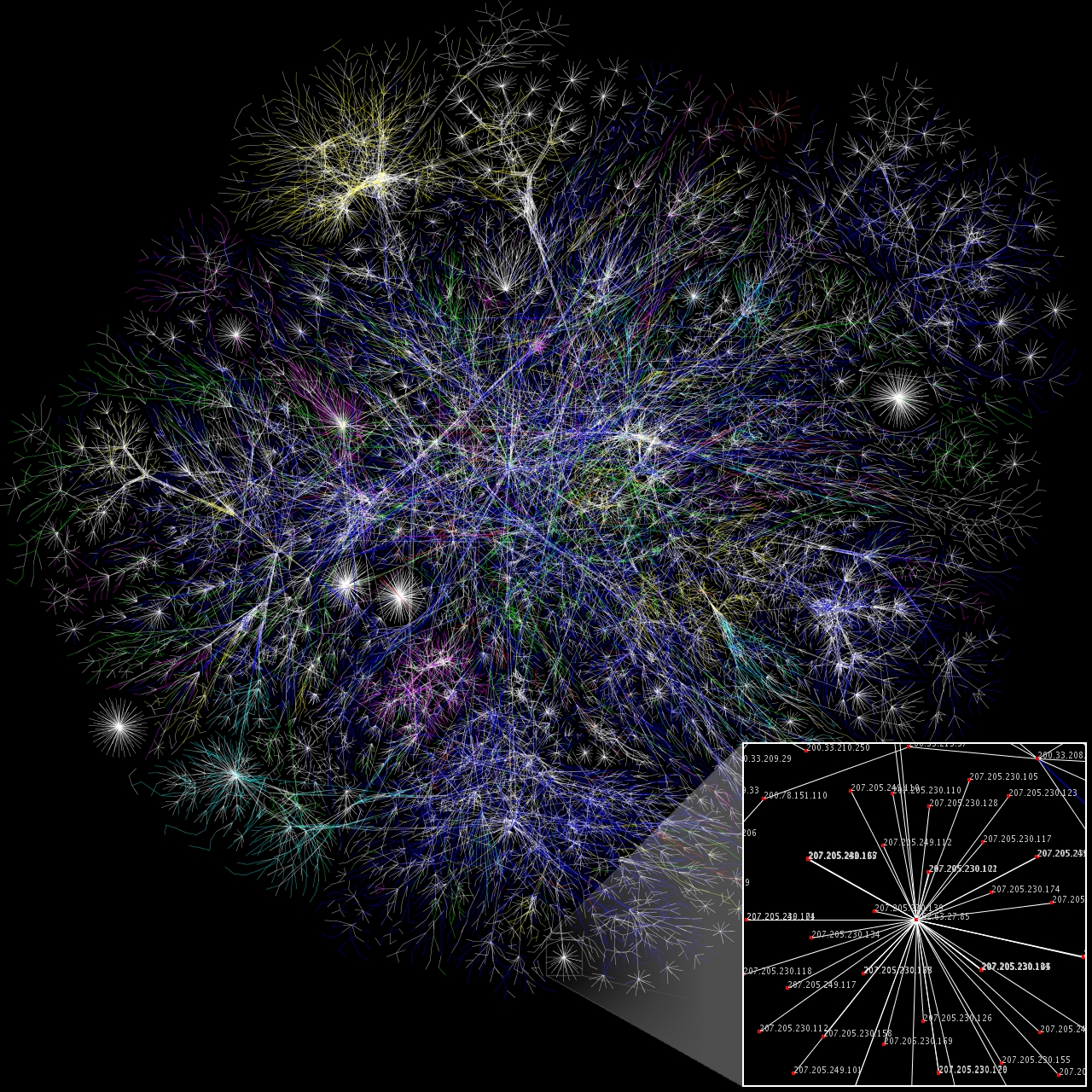

Conheça a Biblioteca de Softwares do Internet Archive

Felipe Mamone O Internet Archive é uma organização sem fins lucrativos que se dedica incansavelmente a preservar a história da internet. Sua missão fundamental é proporcionar “acesso universal a todo o conhecimento”, atuando como uma…

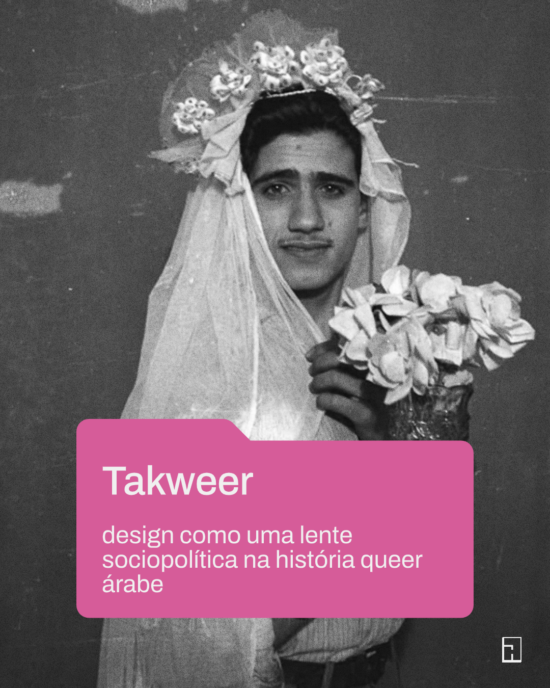

TAKWEER: DESIGN COMO UMA LENTE SOCIOPOLÍTICA NA HISTÓRIA QUEER ÁRABE

Rian Souza Na história árabe antiga, durante a era dos primeiros califados islâmicos, existiam inúmeras menções a relacionamentos entre pessoas do mesmo gênero; a maioria delas é sobre homens, mas há algumas que também falam…

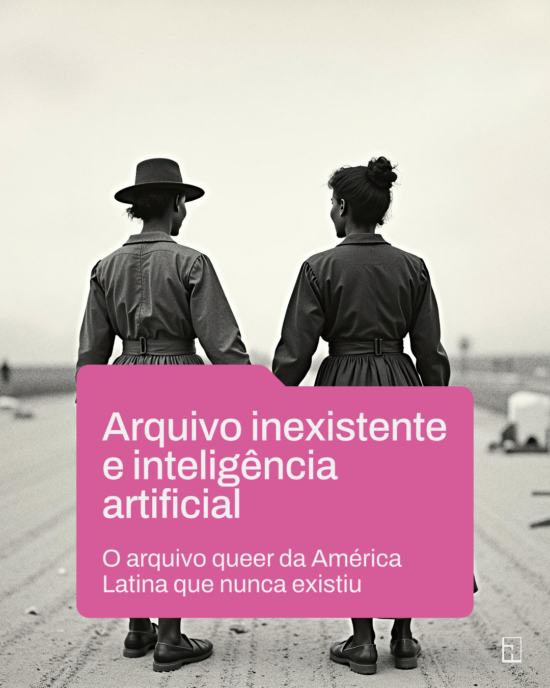

Arquivo inexistente e inteligência artificial

Rian Souza Você já imaginou trabalhadores rurais se beijando ou trabalhadores têxteis se abraçando apaixonadamente? Em ‘Um Arquivo Inexistente’, o artista Felipe Rivas San Martín recria um passado queer na América Latina usando inteligência artificial….

A FORÇA DE SER O QUE SE É

Rian Souza Destaques da exposição “Ney Matogrosso” no MIS A exposição “Ney Matogrosso” está aberta ao público no MIS (Museu da Imagem e do Som). Nós do Acervos Digitais e Pesquisa tivemos o prazer de…

Livro sobre Acervos Digitais e Patrimônio

Cássia Hosni Livro “Digital Archives and Collections: Creating Online Access to Cultural Heritage”, de Katja Müller, discute digitalização e o acesso ao patrimônio material nos acervos fotográficos A publicação dá ênfase aos arquivos digitais, com…

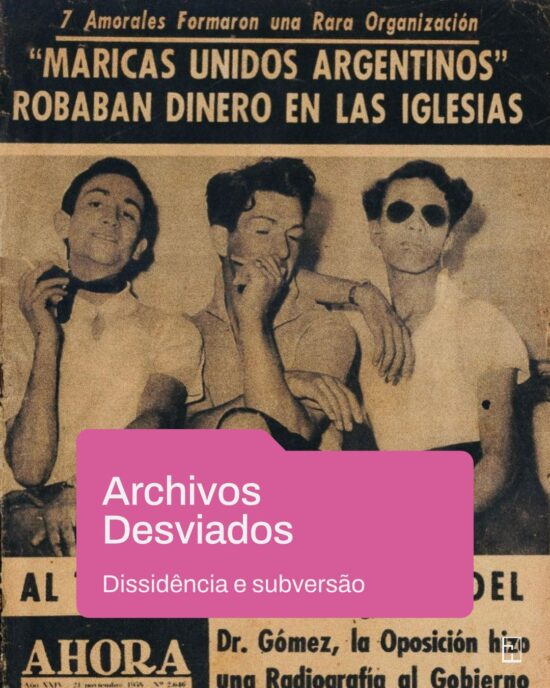

ARCHIVOS DESVIADOS

Rian Souza O projeto Archivos Desviados atua no campo da preservação de documentos e recuperação de memórias queer, criado em 2019, em Buenos Aires, por Juan Queiroz, ativista LGBTQIA+, arquivista, editor e cofundador do portal…

QUEER INDONESIA ARCHIVE (QIA)

Rian Souza O Queer Indonesia Archive é um acervo digital sem fins lucrativos, o projeto é administrado por voluntários e focado na comunidade. Está comprometido com a compilação, a preservação e a celebração de materiais…

A Plataforma Tainacan

Felipe Mamone O Tainacan, um software livre desenvolvido pela Universidade de Brasília com apoio da Universidade Federal de Goiás, do Instituto Brasileiro de Informação em Ciência e Tecnologia e do Instituto Brasileiro de Museus, é…

Rastreamento Ocular: uma ferramenta inovadora para a Museologia

Está disponível no YouTube a palestra do Professor Raphael Rosenberg, Professor Visitante do nosso Projeto Temático. Realizada no MAC-USP, com organização da Pesquisadora Ana Gonçalves Magalhães, a palestra discutiu o uso de rastreamento ocular no…

Domingo no Golpe (documentário)

Domingo no Golpe é um documentário “Ready Media” Giselle Beiguelman e Lucas Bambozzi sobre a tentativa de golpe de Estado ocorrida em 8 de janeiro de 2023. A definição, alude a obras em que os…

Inteligência Artificial em Museus

Neste seminário, ministrado pela pesquisadora Renata Perim, foram analisados 15 sites de museus que estão utilizando recursos de Inteligência Artificial no tratamento e divulgação de seus acervos. Sites analisados: The Museums + AI Network MoMA…

Estudos de caso: arquivos contra-hegemônicos

Nossas discussões sobre formatos de arquivos contra-hegemônicos e distribuídos focaram alguns estudos de caso. Esses estudos são fundamentais para nos aproximar do desenho que queremos para formular o acesso a acervos que não existem, especialmente…